Buongiorno, signori. Io sono un elaboratore HAL 9000.

A me piace lavorare con la gente. Ho rapporti diretti ed interessanti con il dottor Poole e con il dottor Bowman. Le mie responsabilità coprono tutte le operazioni dell’astronave, quindi sono perennemente occupato. Utilizzo le mie capacità nel modo più completo; il che, io credo, è il massimo che qualsiasi entità cosciente possa mai sperare di fare.

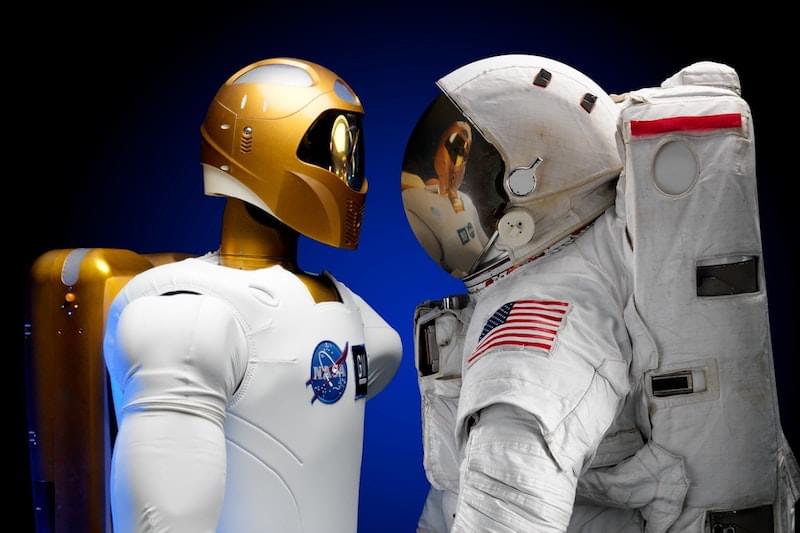

Che Stanley Kubrick, nel 1968, fosse affascinato dall’Intelligenza Artificiale è facile intuirlo dai dialoghi del calcolatore HAL 9000 che si auto-definisce entità cosciente. Il termine Intelligenza Artificiale nasce a metà degli anni cinquanta e da allora ha assunto disparati significati, ma il sogno è sempre quello: creare macchine la cui intelligenza sia comparabile, se non uguale, a quella umana.

Per questo, forse, tra tecnici è più comune sentir parlare di Machine Learning o più recentemente Deep Learning, un’implementazione del Machine Learning, la tecnica che consente (o dovrebbe consentire) di determinare delle regole di comportamento o addirittura predire tali comportamenti grazie all’analisi dei dati e all’apprendimento dagli stessi.

2010: Il Deep Learning.

È con il Deep Learning, poi, che questa tecnica diventa più strutturata. Diciamolo, il Machine Learning (negli anni ottanta e per i successivi trent’anni), inizialmente e ampiamente usato nella visione artificiale, non aveva il sapore dell’Intelligenza Artificiale da film: i computer erano in grado di determinare dove finiva un oggetto e ne iniziava un altro, i numeri di targa delle automobili o magari la segnaletica stradale (ma solo se non c’era nebbia!). Il Deep Learning, ispirato alle reti neurali, ispirate a loro volta dal funzionamento sinaptico del cervello umano, ha portato l’Intelligenza Artificiale ad un altro livello: più reti neurali (layer), debitamente istruite grazie all’analisi di migliaia o milioni di dati, elaborano l’input e passano il risultato alla rete successiva che a propria volta lo analizza e lo passa alla rete ancora successiva e così via, fino ad arrivare al risultato finale, anzi, sarebbe meglio dire ai risultati finali: una percentuale - probabilistica - di quanto la lettera A di una targa automobilistica possa essere realmente una A (78%, sparo a caso) piuttosto che una R (16%, molto somigliante) o una H (5%, meno somigliante - 1% distribuito sulle altre lettere).

Nessun calcolatore 9000 ha mai commesso un errore o alterato un’informazione. Noi siamo, senza possibili eccezioni di sorta, a prova di errore, e incapaci di sbagliare.

Le informazioni, i dati. Usati da HAL 9000, importanti nel Machine Learning, fondamentali nel Deep Learning dove le reti per il riconoscimento delle immagini vengono istruite, ad esempio, grazie a milioni e milioni di foto pre-classificate: questo è un gatto, questo è un topo e quest’altro un elefante…

I dati. Una moltitudine di dati. I Big Data, informazioni tanto grandi da non poter essere trattate con strumenti tradizionali. Sono i dati, la poca artificiosità degli stessi, la loro concretezza, a mio avviso, il vero tesoro che hanno in mano le aziende.

La capacità di calcolo - necessaria per l’elaborazione di tutti queste informazioni - aumenterà sempre di più nel corso degli anni; gli algoritmi si inventano, si creano, si implementano. I dati no, devono essere acquisiti, copiosi, precisi, classificati. Se le sinapsi umane sono i neuroni artificiali, i dati sono gli input che arrivano dai nostri “sensori”: dai nostri occhi, dalle narici, dalla pelle… milioni di informazioni al secondo.

Twitter mi conosce meglio di quanto non mi conosca io stesso.

Pensiamo alla mole di dati che Facebook, Twitter, Google - ad esempio - hanno a disposizione per istruire i propri sistemi di Deep Learning, per far loro riconoscere i nostri amici e parenti, l’espressione triste o felice del volto, il tono scherzoso o meno di un tweet, la tipologia di ricerca che stiamo effettuando o i nostri interessi… A proposito di Twitter, facciamo un esperimento: pagina I tuoi dati di Twitter, eccoli, di nuovo, i dati. Allora scopro che Twitter riesce a definire i miei interessi meglio di quanto non riesca io stesso: Database, Documentari, Fiere della tecnologia, Front-End Programming, Imprenditorialità, Leadership, Linux, Mac OS, No profit, Notizie scientifiche, Notizie sulla tecnologia, Open source, Programmazione, PHP Programming, Reti di computer, Software Engineers, Web Development e potrei continuare ancora a lungo.

Quando i dati, classificati, alimentano sistemi di Deep Learning, sempre più precisi, complessi, veloci, il risultato è esplosivo!

Per un’azienda o un’organizzazione percepire, o aver percepito, l’importanza della concretezza dei dati è fondamentale: sarà grazie all’utilizzo degli stessi, ad esempio, che si riusciranno a creare modelli predittivi della realtà, previsioni del tempo che funzionano non solo in campo economico o sociale ma individuale: chi potrebbe piacerci di più per andare a mangiare una pizza? E per una notte di sesso? E per una vita insieme? E quale, tra milioni di case, è quella più adatta a noi? Grazie all’avanzamento tecnologico - software e hardware - e alla raccolta e classificazione dei dati le risposte a questi quesiti saranno (sono) realtà, non trovi HAL?